A DeepSeek, startup chinesa de IA, lançou em 25 de março de 2025 sua versão mais recente de modelo de linguagem, o DeepSeek-V3 0324. Trata-se de um modelo open source licenciado sob MIT e disponibilizado no Hugging Face.

O DeepSeek-V3-0324 mantém a arquitetura Mixture-of-Experts (MoE) de 671 bilhões de parâmetros (dos quais cerca de 37 bilhões são ativados por token), com Multi-Head Latent Attention (MLA) otimizada. Seu conjunto de pré-treinamento incluiu 14,8 trilhões de tokens de dados diversos.

A janela de contexto foi expandida em duas etapas – inicialmente para 32 mil tokens e depois para até 128 mil tokens – o que permite lidar com textos muito longos.

Graças a inovações como predição múltipla de tokens (MTP) e balanceamento dinâmico de carga, o novo modelo gera texto cerca de três vezes mais rápido que o antecessor (atingindo ~60 tokens por segundo).

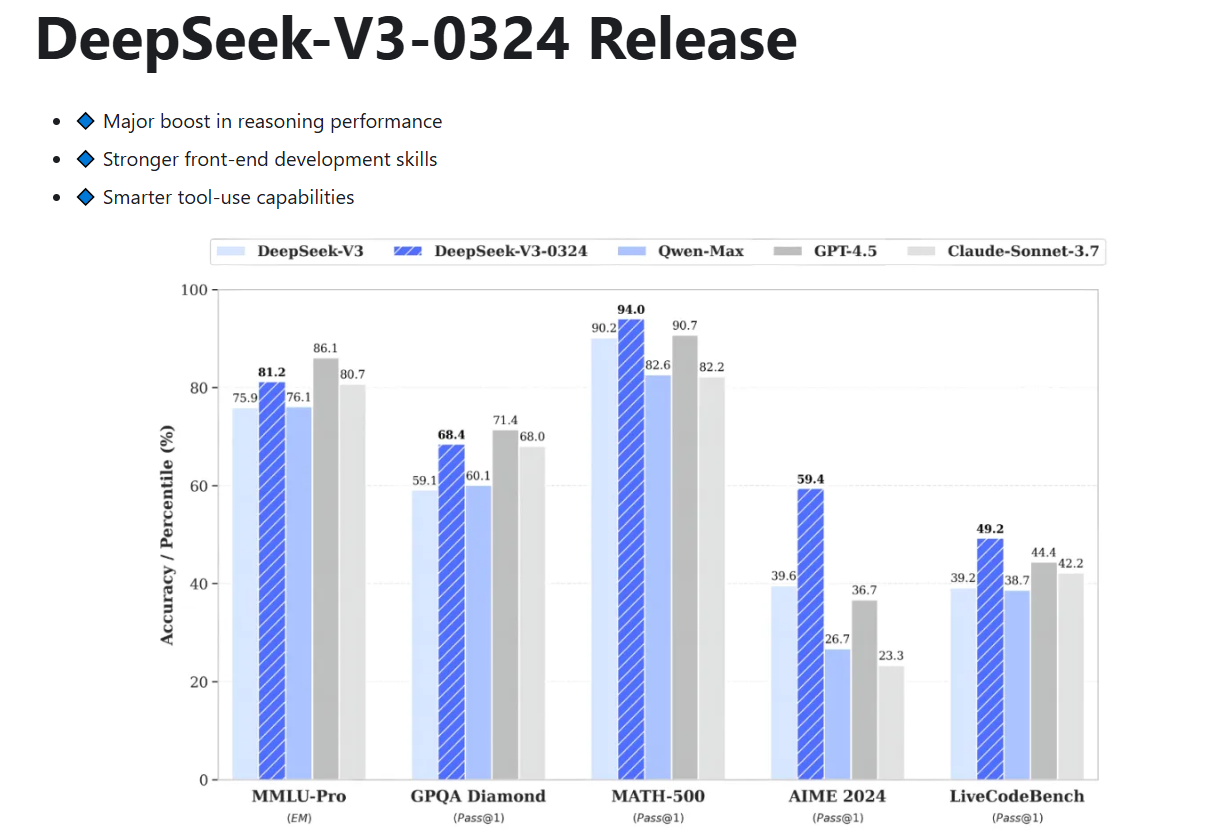

Desempenho e comparações com concorrentes

Nos benchmarks divulgados pela própria DeepSeek, o DeepSeek-V3 supera consistentemente outros modelos de código aberto de grande porte. Segundo testes internos, ele obtém resultados melhores que o Llama-3.1-405B e que o Qwen-2.5-72B em praticamente todos os conjuntos avaliados.

Em muitas métricas o DeepSeek-V3 0324 chegou perto dos níveis dos modelos proprietários, até ultrapassando o GPT-4 (versão GPT-4o) na maioria dos testes, com exceção de algumas tarefas de inglês específico (como SimpleQA e FRAMES) onde o GPT-4 manteve vantagem.

O único rival fechado que mostrou superioridade em algumas métricas foi o Claude 3.5 Sonnet (Anthropic), que obteve pontuações maiores em avaliações selecionadas de matemática avançada e raciocínio complexo.

Destaca-se que o DeepSeek-V3-0324 obteve desempenho especialmente forte em benchmarks de matemática e de língua chinesa, superando todos os demais concorrentes nessas áreas.

(Modelos multimodais de última geração, como o Google Gemini 1.5/2.5, continuam liderando em versatilidade de entrada de imagens e multimodalidade, mas o DeepSeek-V3-0324 foca em tarefas textuais e de codificação de alto nível.)

Casos de uso e aplicações práticas

O DeepSeek-V3-0324 foi projetado para atender a uma variedade de aplicações práticas. Na área de desenvolvimento de software, ele se destaca em tarefas de geração e revisão de código, como indicam pontuações altas em benchmarks de codificação.

A capacidade de gerar saídas em JSON estruturado e de chamar funções permite integrá-lo facilmente em pipelines automáticos (funcionalidade function calling).

Em produtividade empresarial, o modelo pode auxiliar na redação e análise de textos longos, sumarização de relatórios e suporte a atendimento ao cliente.

Também é adequado para projetos de processamento de linguagem natural multilíngue: por exemplo, demonstra alta proficiência em escrita chinesa aprimorada, tornando-o útil em contextos educacionais e de conteúdo em mandarim.

Além disso, pela infraestrutura open source, empresas e desenvolvedores podem ajustar o DeepSeek-V3-0324 para domínios específicos – incluindo criar chatbots, realizar análises de documentos e implementar assistentes virtuais sob medida.

A DeepSeek fornece ainda uma plataforma de conversa online (DeepSeek Chat) e API comercial, facilitando o uso pelos usuários finais.

Vale notar que, embora o foco atual seja texto puro, a empresa já estuda modelos multimodais de visão+texto (como o DeepSeek-VL2), que indicam esforços futuros para incorporar análise de imagens.

Licença e disponibilidade

O DeepSeek-V3-0324 foi lançado como um modelo de código aberto. O código-fonte e os pesos estão disponibilizados sob licença MIT, uma das mais permissivas do mercado, conforme destacam analistas.

O modelo pode ser baixado no Hugging Face (formato safetensors), onde consta como de uso livre sob essa licença.

Além do Hugging Face, a DeepSeek oferece hospedagem por meio de provedores em nuvem: por exemplo, versões anteriores do DeepSeek estão disponíveis no Microsoft Azure (Azure AI Foundry) e em catálogos de IA de outros provedores, o que facilita a integração corporativa.

Em geral, qualquer usuário pode executar o DeepSeek-V3-0324 localmente (há guias oficiais), usar APIs públicas ou serviços de inferência de terceiros (como a Novita, listada no Hugging Face).

Reação da comunidade e imprensa

Especialistas de tecnologia e imprensa especializada reagiram positivamente ao lançamento. A TechTarget observou que o modelo foi disponibilizado no Hugging Face e destacou melhorias em raciocínio e codificação.

Analistas elogiaram a licença MIT adotada — Bradley Shimmin (The Futurum Group) considerou-a “uma das mais permissivas do mercado”, reforçando que outros fornecedores devem seguir licenças abertas de verdade.

Andy Thurai (Constellation Research) comentou que a hospedagem no Hugging Face só acontece após certo nível de validação, o que confere credibilidade extra ao lançamento.

Por outro lado, surgiram também debates geopolíticos: reportagens ressaltam que legisladores nos EUA chegaram a propor proibir o DeepSeek em órgãos governamentais, refletindo preocupações de segurança ao se adotar tecnologias estrangeiras.

No geral, a comunidade técnica destaca que o DeepSeek-V3-0324 demonstra como modelos abertos estão alcançando, e às vezes ultrapassando, as soluções proprietárias tradicionais – um avanço visto como positivo para a diversidade de opções em inteligência artificial.