O DeepSeek Math é um modelo de linguagem de inteligência artificial altamente especializado em raciocínio matemático. Desenvolvido pela DeepSeek AI, ele foi treinado para resolver problemas complexos de matemática, incluindo álgebra, cálculo, geometria, estatística e muito mais. Diferentemente dos modelos de propósito geral, que muitas vezes falham em matemática avançada, o DeepSeek Math enfatiza a precisão lógica e a decomposição estruturada de problemas, gerando explicações passo a passo claras e rigorosas. Isso o torna especialmente relevante para desenvolvedores de IA que trabalham em aplicações educacionais, tutores inteligentes, sistemas de resolução simbólica e outros cenários onde compreender e resolver problemas matemáticos de forma automática é fundamental.

A relevância do DeepSeek Math para profissionais de IA reside na sua capacidade de entender linguagem matemática tanto simbólica quanto natural. Ou seja, ele consegue interpretar problemas descritos em texto comum (linguagem natural) ou em notação formal (como expressões algébricas ou LaTeX). Por ter sido treinado em um vasto conjunto de dados matemáticos que vão desde conceitos de nível escolar até questões de olimpíadas de matemática, o modelo é capaz de lidar com questões de variados níveis de dificuldade. Em suma, o DeepSeek Math representa um avanço significativo no campo de modelos de linguagem para matemática, oferecendo uma ferramenta poderosa e de código aberto para que desenvolvedores incorporem capacidade de resolução de problemas matemáticos em suas aplicações.

Processamento de Linguagem Matemática no DeepSeek Math

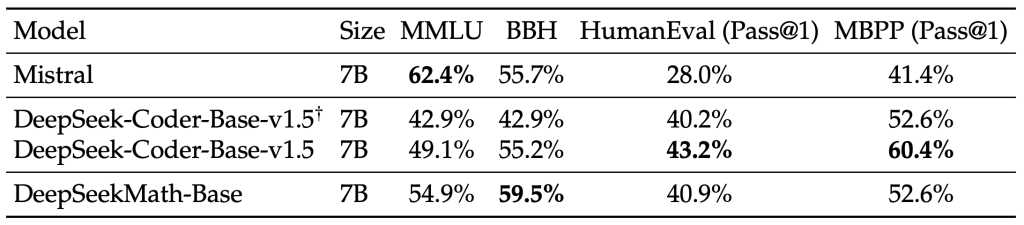

O DeepSeek Math foi construído sobre uma arquitetura transformadora moderna, inicializada a partir de um modelo especializado em código (DeepSeek Coder v1.5) com 7 bilhões de parâmetros. Esse ponto de partida com conhecimento de programação provou ser vantajoso para raciocínio matemático simbólico, já que manipular matemática muitas vezes se assemelha a manipular linguagem de programação em termos de estrutura e lógica. Em seguida, o modelo passou por um extenso pré-treinamento em um corpus massivo de dados matemáticos contendo 120 bilhões de tokens de conteúdo especializado em matemática, extraídos da web (Common Crawl) e de fontes científicas de alta qualidade. No total, incluindo dados gerais e código, o treinamento do DeepSeek Math abrangeu cerca de 500 bilhões de tokens, o que lhe conferiu um conhecimento amplo e profundo em diversas áreas da matemática.

Uma das grandes inovações do DeepSeek Math é como ele processa tanto a linguagem natural quanto a notação simbólica de forma integrada. O modelo possui vocabulário e embeddings capazes de representar expressões matemáticas (como fórmulas em LaTeX) ao lado de texto comum, permitindo que ele compreenda perguntas do tipo “Explique a prova do Teorema de Pitágoras” assim como “$\int_0^2 x^2,dx$”. Além disso, durante seu ajuste fino, foi incorporada a técnica de chain-of-thought (cadeia de raciocínio), na qual o modelo é incentivado a quebrar problemas em etapas intermediárias antes de chegar à solução final. Por exemplo, se questionado sobre a solução de uma equação quadrática, o DeepSeek Math primeiro descreve o cálculo do discriminante, depois aplica a fórmula de Bhaskara, e assim por diante, documentando cada passo do raciocínio. Essa abordagem estruturada melhora a precisão e a clareza das respostas, pois evita saltos lógicos e omissão de etapas importantes no raciocínio matemático.

Outro aspecto técnico fundamental é o uso de aprendizado por reforço para ajuste fino do modelo. Após o pré-treinamento e uma fase de instrução supervisionada (instruindo o modelo a seguir comandos e perguntas), os criadores do DeepSeek Math aplicaram uma técnica de reforço chamada Group Relative Policy Optimization (GRPO) – uma variante otimizada do algoritmo PPO. O GRPO dispensa a necessidade de um modelo crítico separado e ajusta o modelo principal usando feedback binário (correto/incorreto) em problemas matemáticos. Esse passo adicional de RL conseguiu elevar significativamente o desempenho do modelo em problemas desafiadores, obtendo ganhos notáveis em benchmarks matemáticos com eficiência de treinamento aprimorada. Em essência, o DeepSeek Math aprendeu não apenas a resolver problemas matemáticos, mas a apresentar soluções da mesma forma que um professor ou tutor humano faria, graças à combinação de treinamento supervisionado com chain-of-thought e ajustes via reforço para respostas mais claras e detalhadas.

Principais Características Técnicas do DeepSeek Math

- Raciocínio Matemático Avançado: O modelo demonstra proficiência em diversos domínios da matemática, incluindo álgebra, cálculo, estatística, geometria e mais. Ele é capaz de realizar deduções lógicas complexas, provas de teoremas e manipulações simbólicas, indo além de apenas calcular respostas numéricas.

- Janela de Contexto Ampla: O DeepSeek Math suporta entradas extensas – em certas implementações, até 64 mil tokens de contexto – o que possibilita analisar problemas de múltiplas etapas em detalhe. Isso significa que é viável fornecer ao modelo problemas longos, como demonstrações completas ou conjuntos inteiros de equações, e ainda assim obter uma solução coerente. (Nas versões de código aberto padrão, o contexto é de 4096 tokens, mas a plataforma DeepSeek oferece janelas expandidas para casos de uso que demandam contexto extra longo.)

- Suporte a Linguagem Natural e LaTeX: O modelo entende tanto problemas matemáticos descritos em português/inglês coloquial quanto expressões em notação formal (por exemplo, notação LaTeX). Ele pode inclusive gerar soluções formatadas em LaTeX com equações dentro de

\boxed{}para destacar a resposta final, o que é muito útil na criação de conteúdo acadêmico ou relatórios técnicos. - Disponibilidade via API e Open-Source: O DeepSeek Math pode ser acessado por meio de uma API REST oferecida pela DeepSeek, facilitando sua integração em aplicações web, bots ou sistemas educacionais. Além disso, o modelo (em suas versões base e de instrução) está disponível como projeto de código aberto, possibilitando que desenvolvedores o utilizem localmente e até mesmo o personalizem via fine-tuning para necessidades específicas. A licença do modelo permite uso comercial livremente, o que significa que você pode incorporá-lo em produtos e serviços sem preocupações com royalties ou restrições de uso.

Casos de Uso e Exemplos Práticos

Como um modelo voltado para matemática, o DeepSeek Math abre diversas possibilidades de aplicações no mundo real.

A seguir, alguns casos de uso práticos onde desenvolvedores de IA de nível médio/avançado podem aproveitar suas capacidades:

- Resolução de Problemas Matemáticos Geral: Resolver automaticamente questões de álgebra, cálculo, probabilidade, estatística e outras áreas, fornecendo tanto a resposta quanto o processo de resolução. Isso se aplica desde problemas de nível básico (ensino médio) até desafios de olimpíadas matemáticas.

- Geração de Soluções Passo a Passo: Produzir explicações detalhadas para cada etapa da solução de um problema. Por exemplo, em ambientes educacionais, o DeepSeek Math pode atuar como um assistente que mostra cada passo do cálculo ou da demonstração, ajudando estudantes a entenderem o raciocínio por trás da resposta.

- Computação Simbólica e Provas de Teoremas: Auxiliar em sistemas de álgebra computacional ou em verificadores de prova, fornecendo deduções simbólicas. O modelo consegue manipular expressões algébricas simbolicamente e até esboçar provas de teoremas ou lemmas, tornando-o útil em pesquisa matemática e em desenvolvimento de softwares de demonstração automática.

- Tutoria Inteligente de Matemática: Integrado em um chatbot, o DeepSeek Math pode atuar como um tutor virtual, respondendo dúvidas de alunos em linguagem natural e explicando conceitos. Usando frameworks como LangChain, por exemplo, pode-se construir um assistente que dialogue com o usuário, guie-o na resolução de exercícios e corrija seus equívocos de forma interativa.

- Assistente em Pesquisa Científica e Engenharia: Em ambientes de pesquisa, o modelo pode ser empregado para verificar derivações matemáticas em papers, calcular resultados intermediários em análises de dados ou até sugerir caminhos para resolver equações diferenciais em engenharia. Ele serve como um “co-piloto” capaz de validar cálculos e apontar possíveis erros em deduções complexas.

- Apoio em Algoritmos e Códigos que envolvem Matemática: Para desenvolvedores trabalhando em projetos de software científico ou financeiro, o DeepSeek Math pode ajudar a gerar algoritmos ou trechos de código relacionados a problemas matemáticos. Por exemplo, ele pode sugerir como implementar uma determinada fórmula em Python ou verificar a corretude lógica de um algoritmo matematicamente intensivo.

Para ilustrar na prática, vejamos um exemplo simples de uso do DeepSeek Math via Python. Suponha que queremos calcular uma integral definida e obter a solução passo a passo:

# Exemplo: resolvendo uma integral com o DeepSeek Math

# (A pergunta está em inglês para refletir o treinamento principal do modelo)

from transformers import AutoTokenizer, AutoModelForCausalLM

model_name = "deepseek-ai/deepseek-math-7b-instruct"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name, device_map="auto", torch_dtype="auto")

question = "What is the integral of x^2 from 0 to 2? Please reason step by step, and put your final answer within \\boxed{}."

inputs = tokenizer(question, return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_new_tokens=100)

result = tokenizer.decode(outputs[0], skip_special_tokens=True)

print(result)

No código acima, usamos a biblioteca Hugging Face Transformers para carregar o modelo de instrução (7B) do DeepSeek Math e enviamos uma pergunta: “Qual é a integral de x^2 de 0 a 2? Por favor, raciocine passo a passo e coloque sua resposta final dentro de \boxed{}.” (optamos por escrever a pergunta em inglês para garantir melhor desempenho, já que a maior parte dos dados de treinamento do modelo está em inglês).

Ao executar esse script, o modelo retornará uma resposta detalhada, por exemplo, explicando que a antiderivada de $x^2$ é $x^3/3$, avaliando nos limites 0 e 2, e concluindo com a resposta final $\boxed{\frac{8}{3}}$. Observe que a instrução especial “reason step by step, and put your final answer within \boxed{}” (em português, “raciocine passo a passo e coloque a resposta final dentro de \boxed{}”) é uma boa prática para interação com o DeepSeek Math. Essa dica de formatação explora o treinamento de cadeia de raciocínio do modelo, fazendo com que ele explicite cada etapa e destaque a resposta, o que é útil em diversos cenários.

Nos exemplos acima, vemos como integrar o modelo diretamente em Python, mas também poderíamos acessar funcionalidades semelhantes via uma API REST fornecida pela plataforma DeepSeek, dependendo do caso de uso.

Benefícios de Usar o DeepSeek Math em Aplicações Reais

O DeepSeek Math traz diversos benefícios para aplicações de IA focadas em matemática, graças à sua especialização e design. A seguir, destacamos os principais benefícios de utilizá-lo em projetos reais:

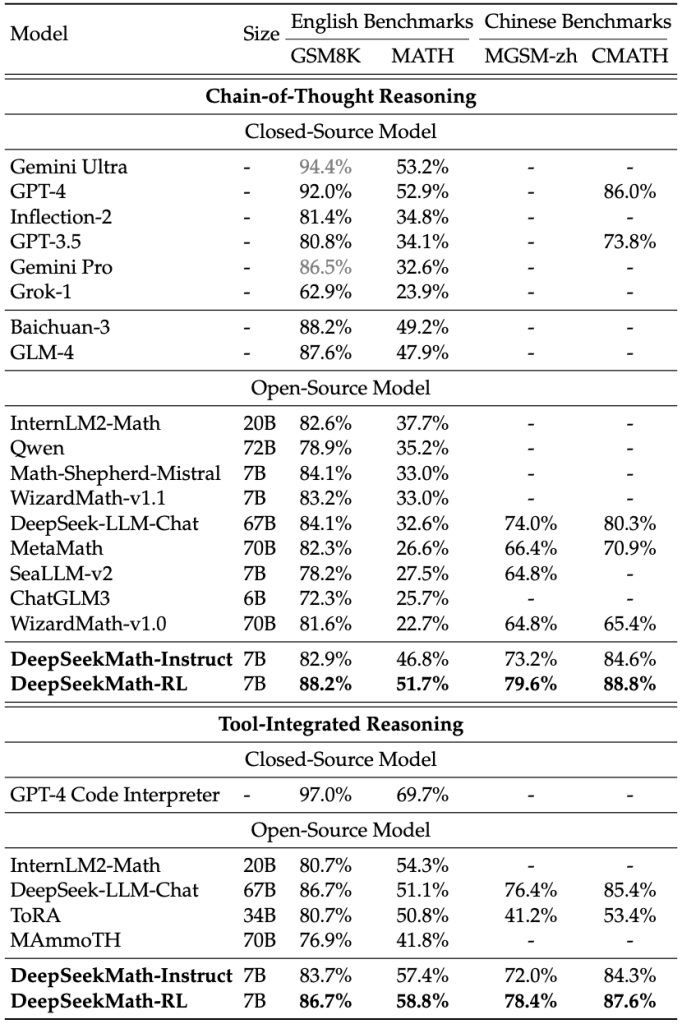

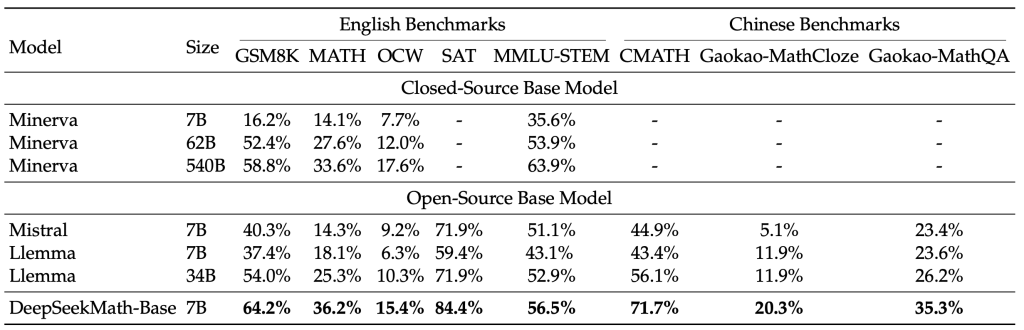

- Desempenho Superior em Tarefas Matemáticas: Por ter sido treinado em uma quantidade enorme de dados matemáticos e afinado especificamente para raciocínio quantitativo, o DeepSeek Math alcança resultados de ponta em benchmarks do domínio. Por exemplo, ele resolve corretamente cerca de 60% dos problemas de nível de competição do conjunto MATH e mais de 90% das questões do conjunto GSM8K (matemática de nível escolar). Esses números atestam uma precisão muito acima do obtido por modelos genéricos de tamanho semelhante, tornando-o confiável para uso em produção em tarefas que exigem cálculos e lógica matemática apurada.

- Soluções Transparentes e Explicáveis: Diferentemente de “caixas-pretas” que apenas dão uma resposta final, o DeepSeek Math praticamente mostra seu trabalho – ele fornece o passo a passo do cálculo ou prova. Essa transparência é valiosa em ambientes educacionais (onde é importante ver como se chegou ao resultado) e também em aplicações críticas, pois permite ao desenvolvedor ou usuário auditar o raciocínio do modelo. A saída geralmente inclui explicações em linguagem natural e notação matemática bem formatada, facilitando a validação e entendimento.

- Facilidade de Integração e Customização: Sendo disponibilizado tanto via API quanto como modelo open-source, é simples integrar o DeepSeek Math a fluxos de trabalho existentes. Desenvolvedores podem chamá-lo em serviços web para resolver problemas sob demanda, ou incorporar localmente usando frameworks populares de ML. Além disso, por ser aberto, é possível personalizá-lo via fine-tuning – por exemplo, treinando-o adicionalmente com problemas específicos de um determinado domínio científico ou em português – para ajustar seu comportamento às necessidades de um projeto.

- Eficiência e Implantação Flexível: Apesar do alto desempenho, o modelo tem apenas 7B parâmetros, o que significa que pode ser executado com recursos computacionais moderados (uma GPU de 16 GB é suficiente na maioria dos casos, e versões quantizadas podem rodar até em CPU). Isso é um grande benefício para quem deseja embarcar a solução em aplicativos ou serviços com orçamento limitado, ou que precise rodar localmente por motivos de privacidade. Em comparação a modelos gigantescos, o DeepSeek Math oferece excelente custo-benefício, entregando capacidade próxima à de modelos muito maiores sem exigir infraestrutura de alto custo.

- Licenciamento Amigável (Uso Comercial): Conforme mencionado, a licença do DeepSeek Math permite uso comercial. Esse é um benefício crucial para empresas e desenvolvedores independentes – diferente de alguns modelos cujo uso é restrito ou pago, o DeepSeek Math pode ser integrado livremente em produtos comerciais, plataformas online, etc. Isso reduz barreiras legais e financeiras, acelerando a inovação e a adoção da solução.

- Comunidade e Evolução Constante: Por ser um projeto aberto e relativamente novo, o DeepSeek Math está em constante aprimoramento. A comunidade de IA pode contribuir relatando problemas, compartilhando conjuntos de dados especializados ou até propondo melhorias no código. Para os desenvolvedores, isso significa que ao adotar o DeepSeek Math, eles estão usando uma ferramenta na vanguarda da pesquisa, com potencial de melhorar ainda mais com o tempo. Novas versões ou modelos relacionados (por exemplo, versões com mais parâmetros ou adaptadas a outros idiomas) podem surgir e serem incorporadas facilmente graças ao ecossistema aberto.

Em resumo, usar o DeepSeek Math em aplicações reais proporciona alta acurácia em cálculos e raciocínios, confiança nas respostas graças à explicabilidade, e flexibilidade de integração – tudo isso sem as amarras de plataformas proprietárias. Esses benefícios permitem criar soluções como assistentes matemáticos, sistemas de tutoring ou módulos de cálculo avançado com qualidade profissional de forma mais rápida e segura.

Boas Práticas de Integração (API e Modelo Base)

Integrar o DeepSeek Math em sua aplicação requer atenção a alguns detalhes para tirar o máximo proveito do modelo. Aqui estão algumas boas práticas tanto para uso via API quanto utilizando o modelo como base localmente:

- Escolha da Versão Adequada do Modelo: A família DeepSeek Math inclui diferentes versões: o modelo base (pré-treinado, sem instrução), o modelo instruído (7B Instruct, ajustado para seguir comandos e fornecer explicações) e o modelo reforçado (7B RL, ajustado com aprendizado por reforço para performance máxima). Para a maioria das aplicações interativas (como chatbots ou resolução de perguntas), recomenda-se usar a versão Instruct ou RL, pois elas entendem melhor as solicitações em linguagem natural e já sabem produzir respostas estruturadas. A versão base pode ser útil caso você queira realizar um fine-tuning customizado em cima dela, mas em geral começar com o modelo instruído garantirá resultados melhores de saída.

- Formatação de Prompt e Encadeamento de Raciocínio: A forma como você faz a pergunta ao modelo influencia muito a qualidade da resposta. Aproveite que o DeepSeek Math foi treinado com métodos de chain-of-thought e sempre formate o prompt incentivando o raciocínio passo a passo. Por exemplo, adicione frases como “Explique seu raciocínio passo a passo e apresente a resposta final em destaque” ao final da pergunta. Conforme a documentação, uma sugestão eficaz é: “Por favor, raciocine passo a passo e coloque sua resposta final dentro de \boxed{}.”. Isso sinaliza ao modelo para fornecer a cadeia lógica completa e colocar o resultado dentro de um

\boxed{}. Essa prática gera respostas mais completas e facilita extrair a resposta numérica/simbólica do meio da explicação, caso necessário. - Gerenciamento de Comprimento de Contexto: Fique atento ao tamanho das perguntas e dados de entrada. Na versão open-source padrão, o DeepSeek Math aceita ~4k tokens de contexto, o que já é suficiente para maioria dos problemas (por exemplo, cerca de 5-6 páginas de texto). Se seu caso de uso exigir enviar textos muito longos (como um capítulo inteiro de livro ou uma prova extensa), considere dividir em partes ou utilizar a versão com janela expandida (disponível via API) que comporta até ~64k tokens. No output, defina limites de tokens de resposta adequados (

max_new_tokens) para evitar cortes na explicação, mas também para prevenir respostas excessivamente longas. - Infraestrutura e Desempenho: Ao rodar o modelo localmente, garanta que possui recursos computacionais suficientes. Uma GPU com suporte a tensor cores (p. ex. NVIDIA com suporte a bfloat16/FP16) é recomendada para inferência rápida, usando meia precisão como no exemplo de código acima. Para quem não dispõe de GPU potente, opções incluem usar quantização (ex. int8 ou int4) para reduzir o uso de memória – já existem variantes quantizadas do DeepSeek Math na comunidade. Alternativamente, utilizar serviços de inferência em nuvem ou a própria API hospedada pela DeepSeek pode simplificar a implantação. Lembre-se de que a latência de resposta dependerá do tamanho do modelo (7B é relativamente rápido, geralmente respondendo em poucos segundos para perguntas medianas) e do comprimento da resposta gerada.

- Validação e Pós-processamento: Embora o DeepSeek Math seja extremamente capaz, é sempre bom implementar verificações ou validações nas respostas ao integrar em um produto final. Por exemplo, se a resposta final for um valor numérico crítico (como em um sistema de engenharia), pode-se comparar com um cálculo tradicional (usando uma biblioteca como NumPy/Sympy) para garantir correção. Da mesma forma, para resultados simbólicos, talvez seja útil simplificar a expressão saída – às vezes o modelo pode dar uma fração ou expressão equivalente mas não totalmente simplificada. Em um ambiente de tutor, você pode querer pós-processar a saída LaTeX para apresentar de forma mais amigável ao usuário final. Em suma, integrar o modelo com algumas camadas de verificação pode unir o melhor dos dois mundos: a inteligência generativa do DeepSeek Math com a confiabilidade de sistemas computacionais tradicionais.

- Manutenção e Atualizações: Acompanhe as atualizações do projeto DeepSeek. Sendo uma área em rápido avanço, novos modelos ou versões aprimoradas podem ser lançados (por exemplo, modelos com mais parâmetros ou especializados em outros idiomas). A DeepSeek AI também publica pesquisas (como o paper do DeepSeek Math) e exemplos, portanto mantenha-se informado através do repositório oficial no GitHub e comunidade. Uma boa prática é isolar a integração do modelo em sua aplicação de forma modular, de modo que futuras substituições ou upgrades do modelo possam ser feitas com facilidade.

Seguindo essas práticas, você garantirá uma integração suave do DeepSeek Math, tirando proveito máximo de suas capacidades com o mínimo de contratempos. Seja consumindo via API ou rodando localmente, o importante é estruturar bem as consultas e gerenciar recursos para que o modelo possa brilhar na resolução dos problemas matemáticos propostos.

Desempenho, Capacidade e Limitações

Desempenho e Escalabilidade do Modelo

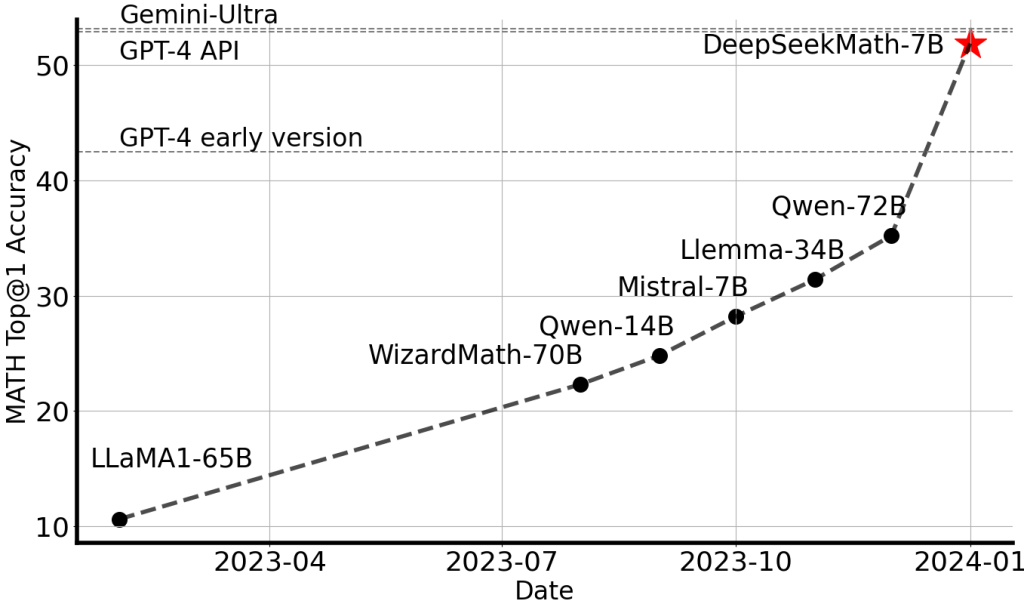

Os resultados obtidos pelo DeepSeek Math nos benchmarks padronizados de matemática são impressionantes, especialmente considerando seu porte de 7B parâmetros. Em avaliações públicas, ele resolve corretamente aproximadamente 59–60% das questões de nível competição do conjunto MATH e atinge cerca de 94% de acurácia no conjunto GSM8K (que contém problemas matemáticos de nível escolar).

Esses números colocam o DeepSeek Math no patamar dos melhores modelos abertos para matemática, e próximo do desempenho de modelos fechados de última geração. Vale notar que, ao aplicar técnicas como self-consistency (onde o modelo gera múltiplas soluções e escolhe a mais comum), a taxa de acerto no MATH pode subir ainda mais – um experimento relatou cerca de 60,9% de acerto usando 64 amostras de cadeia de raciocínio. Em outros benchmarks relevantes, como o GSM8K, o modelo também apresentou resultados excelentes, indicando não só domínio de matemática de competição, mas também forte desempenho em raciocínio geral e lógico (o treinamento matemático robusto acabou por melhorar as habilidades gerais de raciocínio do modelo, refletindo em ganhos em testes como MMLU e Big-Bench Hard, segundo o artigo técnico).

Do ponto de vista de capacidade computacional, o DeepSeek Math foi projetado para maximizar o desempenho dentro de uma escala de modelo relativamente pequena. Seus 7 bilhões de parâmetros ocupam por volta de 14 GB de memória em meia precisão, tornando viável o deploy em uma única GPU de classe média ou alta. Mesmo assim, graças à eficiência dos algoritmos de treinamento (como o GRPO mencionado) e à curadoria inteligente de dados, ele alcança resultados comparáveis a modelos muito maiores. Isso se traduz em eficiência de escalabilidade para desenvolvedores: você obtém alto desempenho matemático sem precisar escalar para dezenas de bilhões de parâmetros.

Além disso, a inferência com 7B parâmetros tende a ser rápida – tipicamente algumas tokenizações por segundo em GPU – o que significa que mesmo aplicações em tempo real (como um chatbot respondendo usuários) podem ser viáveis com o DeepSeek Math. Por fim, o modelo suporta geração de respostas relativamente longas, podendo detalhar soluções extensas quando necessário, contanto que a solicitação caiba na janela de contexto.

Limitações e Considerações

Apesar de todos os méritos, é importante entender as limitações do DeepSeek Math para usá-lo de forma consciente:

- Cobertura Linguística: O foco principal do treinamento do modelo foi em inglês (e em parte, chinês). Isso significa que, embora matematicamente ele seja universal, o desempenho ao interpretar perguntas em português ou outros idiomas pode não ser tão robusto. Problemas apresentados em português simples podem até ser compreendidos se envolvem termos técnicos comuns (muitos termos matemáticos são cognatos entre as línguas), mas há risco de interpretações equivocadas ou de o modelo responder em inglês. Para desenvolvedores brasileiros, uma solução é traduzir a pergunta internamente para inglês antes de enviar ao modelo, ou então fornecer as expressões matemáticas diretamente. Alternativamente, pode-se considerar um fine-tuning adicional do modelo com dados em português, caso o uso no nosso idioma seja crítico para a aplicação.

- Erros e Alucinações Matemáticas: Embora muito competente, o DeepSeek Math não é infalível. Ele pode ocasionalmente cometer erros em soluções, seja por deslizes algébricos, aproximações numéricas ou interpretação errada de um enunciado ambíguo. Modelos de linguagem podem “alucinar” – ou seja, fornecer respostas plausíveis porém incorretas – e no contexto matemático isso pode significar uma conclusão errada apresentada com alta confiança. Portanto, em aplicações críticas, recomenda-se validar as respostas importantes. Por exemplo, se o modelo forneceu a demonstração de um teorema novo, é prudente revisá-la; se deu um resultado numérico, cheque por consistência ou cálculo direto. A boa notícia é que, devido ao estilo “mostrar o trabalho”, fica mais fácil identificar onde um eventual erro ocorreu na linha de raciocínio.

- Limites Computacionais Intrínsecos: O DeepSeek Math opera inteiramente sem ajuda de ferramentas externas (como calculadoras simbólicas ou bancos de dados). Isso é uma escolha de projeto que torna a solução mais simples (tudo é feito nos próprios parâmetros do modelo), porém implica algumas limitações. Por exemplo, se for solicitado a fatoração de um número inteiro muito grande, ou o cálculo de uma integral definida complexa cujo resultado seja um número transcendental, o modelo pode ter dificuldade, pois não tem mecanismos algorítmicos de alta precisão embutidos – ele tenta “lembrar” ou deduzir com base no que aprendeu. Tarefas de matemática muito além do escopo típico (como demonstrar conjecturas abertas ou resolver equações diferenciais altamente especializadas) também podem ficar fora do alcance. Em resumo, o modelo é excelente no que foi treinado, mas não possui inteligência simbólica irrestrita; para certos problemas de nicho, talvez seja preciso complementá-lo com sistemas especializados (por exemplo, usar o DeepSeek Math para entender o problema e esboçar a solução, mas delegar a etapas computacionais exatas a uma ferramenta como Sympy).

- Conteúdo de Entrada/ Saída e Formatação: Outra consideração prática é que o modelo pode ser sensível à formatação do input. Dar entradas bem estruturadas (por exemplo, usar LaTeX para fórmulas, clareza na pergunta) tende a produzir melhores resultados. Da mesma forma, a saída por vezes pode conter notações que requerem pós-processamento. Já mencionamos a utilização de

\boxed{}para destacar respostas; contudo, se a aplicação final não suporta renderização LaTeX, o desenvolvedor terá que converter essa saída para texto plano ou outra representação. Além disso, o modelo pode gerar respostas longas; se apenas o valor final importa, será preciso extrair do contexto. Portanto, planeje a interface considerando essas nuances – possivelmente limitando o modelo a responder de formas específicas (via prompt) ou usando expressões regulares para capturar resultados nas strings de saída.

Em suma, ao conhecer as limitações, podemos mitigar riscos e potencializar os acertos do DeepSeek Math. Mesmo com as restrições mencionadas, ele se mostra uma ferramenta extremamente poderosa no arsenal de um desenvolvedor de IA, oferecendo capacidade sem precedentes de entender e resolver problemas matemáticos complexos de forma automatizada. Com uso cuidadoso e eventualmente combinado a outras técnicas, o DeepSeek Math pode atuar como núcleo de sistemas inovadores em educação, ciência e tecnologia.

Conclusão

O DeepSeek Math representa um marco na convergência entre inteligência artificial e matemática, fornecendo aos desenvolvedores uma ferramenta avançada capaz de compreender problemas matemáticos e gerar soluções passo a passo com precisão. Neste artigo, exploramos o que torna esse modelo especial – desde seu treinamento colossal em dados matemáticos até suas técnicas de raciocínio estruturado – e como você, como desenvolvedor de IA, pode aplicá-lo em casos de uso reais. Com seu desempenho robusto e natureza aberta, o DeepSeek Math democratiza o acesso a um “oráculo” matemático digital, abrindo espaço para inovações em tutoria inteligente, agentes solucionadores de problemas, assistentes de pesquisa e muitas outras aplicações.

A jornada não termina aqui. Se você ficou interessado em explorar o DeepSeek Math em profundidade, vale a pena visitar o site oficial em português para a comunidade DeepSeek. Lá você encontrará recursos adicionais, documentação em língua local e poderá até experimentar o modelo em ação através de uma interface web. Não perca a chance de levar suas aplicações de IA para o próximo nível integrando capacidades avançadas de matemática! Visite o site deepseek-portugues.chat e descubra como o DeepSeek Math pode impulsionar seus projetos – desde já, comece a explorar, testar e inovar com este modelo de IA voltado para o futuro do raciocínio matemático.

Perguntas Frequentes (FAQ)

O que é o DeepSeek Math?

O DeepSeek Math é um modelo de linguagem de inteligência artificial especializado em matemática. Ele foi treinado em um volume massivo de dados matemáticos (equações, problemas, demonstrações) para resolver problemas complexos, fornecer respostas passo a passo e entender tanto notação simbólica quanto linguagem natural. Em resumo, é um “assistente matemático” baseado em IA que desenvolvedores podem usar para automatizar resoluções de cálculos, teoremas e tarefas de raciocínio quantitativo.

Como o DeepSeek Math processa linguagem matemática simbólica e natural?

O modelo processa linguagem matemática usando uma arquitetura transformadora treinada para lidar com texto comum e notação formal simultaneamente. Durante sua preparação, ele aprendeu a reconhecer fórmulas (por exemplo, escrita em LaTeX) e também a interpretar enunciados em inglês ou outras línguas. Além disso, ele utiliza a técnica de “cadeia de raciocínio”, em que divide um problema em etapas lógicas menores, resolvendo cada parte até chegar à resposta final. Assim, se a pergunta envolver matemática simbólica (como uma equação), ele manipula os símbolos; se envolver linguagem natural (como um problema descritivo), ele traduz para passos matemáticos internamente – em ambos os casos entregando uma solução estruturada.

Quais são os casos de uso práticos do DeepSeek Math?

Há diversos casos de uso. Alguns exemplos incluem: sistemas tutores de matemática que ajudam estudantes passo a passo; agentes automatizados que resolvem problemas de álgebra ou cálculo sob demanda (em aplicações móveis ou web); ferramentas de apoio para pesquisadores, capazes de verificar demonstrações ou calcular resultados simbólicos; integração em assistentes virtuais para responder perguntas técnicas envolvendo matemática; e até suporte na geração de código ou algoritmos envolvendo lógica matemática. Basicamente, qualquer aplicação que precise compreender e resolver expressões matemáticas complexas pode se beneficiar do DeepSeek Math.

Como integrar o DeepSeek Math via API ou como modelo base?

O DeepSeek Math pode ser integrado de duas formas principais. Via API, você pode enviar solicitações a um serviço que hospeda o modelo – por exemplo, a plataforma DeepSeek oferece endpoints onde você envia um problema matemático e recebe a solução detalhada. Isso é útil para quem não quer lidar com infraestrutura. Alternativamente, você pode usar o modelo open-source disponibilizado no Hugging Face: basta carregá-lo em um script Python (utilizando bibliotecas como Transformers) e rodá-lo localmente. Nesse caso, certifique-se de ter uma GPU adequada ou usar quantização para desempenho. Em ambos os cenários, é importante formatar bem as perguntas (instruindo o modelo a responder com cadeia de raciocínio) e tratar a saída de acordo com sua aplicação. A documentação oficial e repositórios fornecem exemplos de uso que ajudam nessa integração.

Quais são as limitações do DeepSeek Math?

Apesar de poderoso, o DeepSeek Math tem algumas limitações. Primeiro, seu treinamento linguístico é focado principalmente em inglês (e chinês), o que significa que perguntas em português podem não ser entendidas tão perfeitamente sem adaptação. Além disso, o modelo pode ocasionalmente errar – ele não garante 100% de acertos, especialmente em problemas extremamente complexos ou fora do seu conhecimento de treinamento. Ele também não utiliza ferramentas externas: tudo é baseado no que foi aprendido, então operações matemáticas muito extensas (como fatoração de números gigantes ou cálculos de alta precisão) podem exceder sua capacidade prática. Por fim, há o limite de contexto: a versão padrão aceita alguns milhares de tokens de entrada, então problemas muito longos precisam ser resumidos ou tratados em partes. Conhecer essas limitações permite contorná-las, seja ajustando a forma de uso ou combinando o modelo com outras abordagens quando necessário.

O DeepSeek Math consegue entender e resolver problemas em português?

Em parte, sim, mas não é seu ponto forte. O modelo foi projetado principalmente com foco em problemas em inglês, então a compreensão de enunciados em português pode variar. Termos técnicos matemáticos frequentemente são parecidos em vários idiomas (por exemplo, “derivada” em português e “derivative” em inglês), o que ajuda. No entanto, para obter os melhores resultados, recomenda-se formular as perguntas em inglês ou utilizar notação matemática universal. Alternativamente, pode-se traduzir a pergunta para inglês antes de enviá-la ao modelo e, se necessário, traduzir a resposta de volta para português. Com futuros aprimoramentos ou possíveis versões treinadas em português, essa situação pode melhorar, mas na versão atual essa precaução garante respostas mais confiáveis.