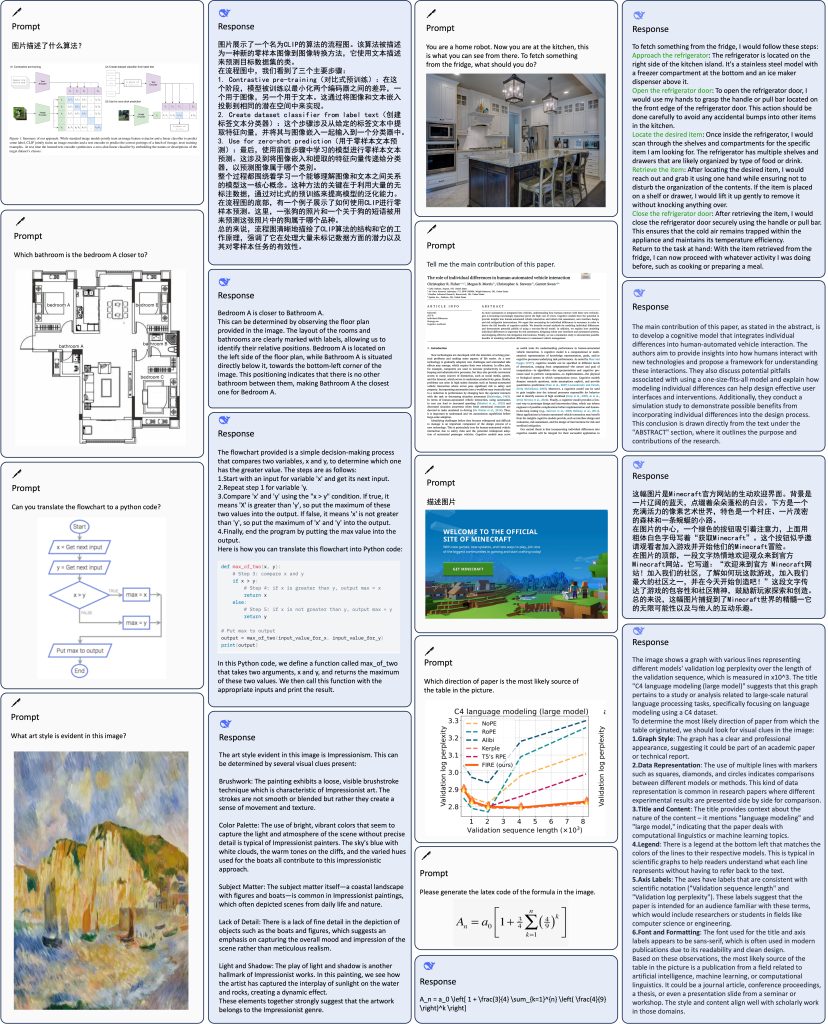

O DeepSeek VL é um modelo multimodal de inteligência artificial que combina visão computacional e linguagem natural em uma única arquitetura. Isso significa que ele pode analisar imagens e textos de forma integrada, permitindo compreender conteúdo visual e textual simultaneamente. Trata-se de um projeto open source (código aberto) concebido para aplicações do mundo real em visão-linguagem, abrangendo desde diagramas lógicos e páginas web até fórmulas científicas, literatura acadêmica e fotografias comuns. Em outras palavras, o DeepSeek VL possui ampla capacidade de entendimento multimodal, apto a processar diferentes tipos de imagens (incluindo gráficos, documentos e cenas naturais) junto com linguagem, visando fornecer respostas ou descrições contextuais.

Desenvolvido inicialmente em 2024, o DeepSeek VL faz parte de uma nova geração de modelos de IA que unem computer vision e NLP (Processamento de Linguagem Natural). Seu objetivo é habilitar análise de imagens orientada por linguagem, como responder perguntas sobre uma figura, descrever o conteúdo visual detalhadamente, ler textos presentes em fotos (OCR) e muito mais. Por ser aberto e voltado à comunidade, desenvolvedores podem utilizá-lo livremente (inclusive comercialmente) em suas próprias aplicações. A seguir, exploraremos em detalhes como esse modelo funciona tecnicamente, suas principais capacidades, exemplos de uso prático e orientações para implementação.

Como o DeepSeek VL Funciona (Processamento Multimodal)

Para combinar entradas de imagem e texto, o DeepSeek VL utiliza uma arquitetura composta por módulos especializados que convergem em um modelo de linguagem. Em alto nível, ele consiste em:

- Encoders Visuais Híbridos: O modelo emprega dois encoders de imagem diferentes em paralelo (chamados SigLIP-L e SAM-B) para extrair informações visuais. Um dos encoders foca em detalhes de alta resolução (aceitando imagens de até 1024×1024 pixels) e características de baixo nível, enquanto o outro opera em resoluções menores (ex.: 384×384) para captar contexto geral e alinhamento com texto. Ao usar múltiplos encoders, o DeepSeek VL obtém uma representação abrangente da imagem, combinando tanto detalhes finos quanto entendimento global da cena.

- Adaptador Visão-Linguagem: As saídas desses encoders visuais são transformadas em um conjunto de tokens visuais (vetores numéricos) compatíveis com o modelo de linguagem. Um módulo adaptador realiza a concatenação e projeção desses recursos visuais para que tenham a dimensão esperada pelo modelo de texto. O resultado são centenas de tokens que representam a imagem, incorporando tanto informações de alta resolução quanto contexto.

- Modelo de Linguagem Natural (LLM): No núcleo, o DeepSeek VL integra um modelo de linguagem pré-treinado de grande porte (chamado DeepSeek-LLM). Essa LLM tem bilhões de parâmetros (por exemplo, 7 bilhões na versão principal) e foi inicialmente treinada apenas em texto (aproximadamente 2 trilhões de tokens de textos diversos), tornando-a proficiente em compreensão e geração de linguagem natural. Após acoplar os encoders de visão, o conjunto completo (visão + linguagem) passou por um extenso treinamento com cerca de 400 bilhões de tokens multimodais, mesclando imagens com descrições e perguntas, para aprender a relacionar elementos visuais e textuais.

- Mecanismo Multimodal Unificado: Durante a inferência (uso do modelo), o usuário fornece uma entrada que pode incluir texto e imagem. Internamente, a imagem é convertida em embeddings através dos encoders e adaptador, e concatenada aos embeddings do texto de entrada. Assim, ambos os tipos de dado são processados juntos pela rede transformer do modelo de linguagem. O DeepSeek VL então gera uma resposta textual que leva em conta tanto a informação visual quanto a pergunta/comando textual fornecido.

Em termos práticos, o modelo aceita prompts com texto e referências de imagem. Por exemplo, pode-se enviar uma mensagem que contenha um marcador especial indicando um local para a imagem (no formato <image_placeholder> em implementações padrão) junto com a pergunta em texto. O modelo retornará uma resposta em linguagem natural que responde ou descreve o que foi pedido com base no conteúdo da figura. Vale destacar que o DeepSeek VL suporta inclusive múltiplas imagens de entrada simultaneamente; desenvolvedores podem fornecer uma lista de imagens em um único prompt para casos de comparação ou contexto visual multi-imagem.

A arquitetura foi projetada para escalabilidade: há duas principais variantes de tamanho – uma de ~1,3 bilhões de parâmetros e outra mais potente de 7 bilhões – ambas disponíveis em versão base (pré-treinada) ou chat (afinada com instruções). A versão chat passou por um ajuste fino adicional com dados de instruções e diálogo multimodal, capacitando o modelo a seguir comandos do usuário e produzir respostas mais conversacionais (ideal para chatbots interativos). Em resumo, tecnicamente o DeepSeek VL funciona integrando um encoder visual duplo a um grande modelo de linguagem, permitindo interpretar imagens dentro de um fluxo textual de maneira eficiente.

Capacidades Principais do Modelo

O DeepSeek VL destaca-se por uma série de capacidades que o tornam muito versátil em tarefas envolvendo visão e linguagem. Entre as principais habilidades estão:

- Análise e Descrição de Imagens: O modelo pode gerar descrições detalhadas de uma imagem, identificando objetos, cenários e ações. Por exemplo, dado uma foto, ele pode listar quem ou o que aparece, descrever o ambiente e até inferir o contexto da cena. Essa capacidade de image captioning enriquecida permite desde legendagem automática de fotos até fornecer contexto visual para usuários.

- Visual Question Answering (VQA): Uma de suas funções centrais é responder perguntas em linguagem natural sobre uma imagem fornecida. Você pode perguntar “Quantas pessoas estão nesta foto e o que elas estão fazendo?” ou “Este diagrama representa qual processo?”, juntamente com a imagem em questão, e o modelo tentará encontrar a resposta olhando para a imagem e entendendo a pergunta. Ele combina reconhecimento de elementos visuais com raciocínio linguístico para fornecer respostas coerentes.

- Reconhecimento Ótico de Caracteres (OCR) e Leitura de Texto em Imagens: O DeepSeek VL foi treinado para extrair e interpretar texto embutido em imagens. Isso inclui ler placas, documentos escaneados, páginas de livro, telas de computador, menus de restaurantes em fotos etc. Além de simplesmente transcrever o texto, o modelo pode compreender o contexto – por exemplo, respondendo a perguntas sobre o conteúdo de um documento ou entendendo legendas em uma figura. Essa habilidade torna-o útil para automatizar tarefas de digitalização e entendimento de documentos (document intelligence).

- Compreensão de Documentos, Tabelas e Gráficos: Diferentemente de modelos de visão tradicionais, o DeepSeek VL consegue interpretar estruturas visuais complexas como tabelas, gráficos de barras/linhas e diagramas técnicos. Você pode fornecer a imagem de um gráfico estatístico e perguntar “Qual foi a tendência de vendas no último trimestre?” que ele buscará “ler” os dados do gráfico para responder. Da mesma forma, pode extrair informação de tabelas em imagens ou compreender fluxogramas e diagramas de processos. Essa competência advém do treinamento em conjuntos de dados específicos de tabelas e gráficos, dando ao modelo noções de eixos, legendas e relações visuais típicas desses formatos.

- Raciocínio Visual e Comunsenso: Combinando visão e linguagem, o DeepSeek VL consegue realizar certo grau de raciocínio multimodal. Por exemplo, pode inferir a sequência de eventos em uma série de imagens, entender causa e efeito numa cena (como deduzir que uma bebida derramada resultou em uma mesa molhada) ou responder a perguntas do tipo “Por que determinada ação está acontecendo na figura?”. Ele também suporta referência a elementos específicos dentro da imagem – capacidade conhecida como visual grounding. Isso significa que se você perguntar “Que objeto está destacado com a seta vermelha na imagem?”, o modelo utiliza as indicações visuais (como a seta) para focar naquela região e responder adequadamente. Essa habilidade de grounding foi incorporada através de dados de treinamento onde partes da imagem eram referenciadas explicitamente.

- Diálogo Multimodal Contextual: Quando utilizado na versão chat, o modelo mantém contexto ao longo de uma conversa contínua envolvendo imagens. Em um chatbot, por exemplo, o usuário pode enviar uma imagem e fazer uma pergunta, receber a resposta, e então fazer perguntas de seguimento baseadas na resposta ou em detalhes adicionais da mesma imagem. O DeepSeek VL consegue lembrar da imagem fornecida e do histórico recente de interação, permitindo um diálogo fluido. Por exemplo: Usuário: “Esta é a foto do meu quarto. O que eu poderia melhorar na organização?” – Assistente: “Vejo que há muitos livros empilhados no canto; talvez uma estante ajudaria. A mesa também está cheia de objetos…” – Usuário: “E quanto à iluminação?” – Aqui o modelo já sabe que estamos falando do quarto da imagem inicial e pode continuar a análise. Esse question answering multimodal multi-turn é extremamente útil para assistentes virtuais interativos.

Em suma, o DeepSeek VL foi projetado para ser um verdadeiro canivete suíço em tarefas de visão e linguagem. Suas capacidades englobam desde tarefas clássicas (como reconhecer objetos e ler texto em imagens) até usos avançados (entender gráficos complexos, responder perguntas de alto nível sobre conteúdo visual e manter conversas sobre imagens). Essa versatilidade abre espaço para inúmeras aplicações, algumas das quais discutimos a seguir.

Casos de Uso Práticos

Desenvolvedores podem aproveitar o DeepSeek VL em diversos cenários do mundo real, impulsionando aplicações inovadoras. A seguir, listamos alguns casos de uso práticos ilustrando como o modelo multimodal pode agregar valor:

- Chatbots com Suporte de Imagem: Os assistentes virtuais tradicionais lidam apenas com texto, mas com o DeepSeek VL é possível construir chatbots que entendem imagens enviadas pelo usuário. Imagine um suporte técnico onde o cliente envia a foto de uma mensagem de erro na tela; o bot pode ler o texto do erro e fornecer instruções de solução. Ou num e-commerce, o cliente envia a foto de um produto que deseja (por exemplo, uma peça de roupa vista em revista) e o chatbot reconhece o item ou algo semelhante no catálogo para recomendar. Em aplicações de atendimento ao cliente, um usuário poderia fotografar um documento ou conta e o bot extrai os dados relevantes e responde às dúvidas. Essa habilidade de compreender imagens torna a experiência do usuário muito mais rica e eficiente, aproximando a interface conversacional da forma como humanos se comunicam (falando e mostrando coisas).

- Diagnóstico Visual Assistido: Na área de saúde e manutenção, o DeepSeek VL pode atuar como um auxiliar na análise de imagens complexas. Por exemplo, em diagnósticos médicos, ele pode ser integrado a um sistema que analisa radiografias, ressonâncias magnéticas ou lâminas de microscópio, apontando possíveis anomalias ou respondendo a perguntas do médico sobre a imagem (“Você observa sinais de fratura? Onde?”). Embora a decisão final caiba sempre a um profissional, um modelo assim pode acelerar triagens e oferecer uma segunda opinião baseada em aprendizado de milhões de imagens. Em manutenção industrial, um técnico pode tirar foto de um equipamento ou peça com defeito e perguntar ao sistema o que poderia estar errado; o modelo então identifica componentes danificados visivelmente (fios desconectados, vazamentos, corrosão etc.) e sugere causas prováveis. Essa aplicação acelera diagnósticos e reduz erros, combinando a percepção visual da máquina com conhecimento técnico embutido nos dados de treinamento.

- Sistemas Educacionais e de Auxílio ao Estudo: Ferramentas educacionais podem se beneficiar enormemente de um modelo que entende imagens. Pense em um aplicativo de estudo onde o aluno tira foto de um problema matemático do livro e o DeepSeek VL não só reconhece o texto da questão, mas também explica passo a passo a solução ou dá dicas de resolução. Em aulas de ciências, o aluno pode fotografar um gráfico ou experimento do laboratório e perguntar ao sistema sobre aquele conteúdo (“O que esse experimento demonstra?”), recebendo uma explicação contextualizada. Outra aplicação é em acessibilidade educacional: estudantes com deficiência visual poderiam usar uma ferramenta que, via câmera, descreve diagramas ou ilustrações de um material didático, convertendo a informação visual em descrição verbal. No âmbito de aprendizado de idiomas, o modelo pode ser usado para treinar vocabulário: o usuário mostra uma imagem (por exemplo, a foto de uma cena na rua) e pede ao assistente para descrevê-la em inglês, praticando assim compreensão auditiva e oral com base no contexto visual.

- Indexação e Busca Multimodal: Em aplicações de gerenciamento de conteúdo e segurança, o DeepSeek VL pode ajudar a indexar imagens por conteúdo. Por exemplo, uma empresa de mídia pode processar seu acervo de fotos e automaticamente gerar descrições e tags para cada imagem (quem aparece, objetos, cenário, texto contido), facilitando buscas posteriores (“encontre imagens de documentos que mencionam ‘confidencial'”, ou “fotos de pessoas assinando contratos”). Em segurança, fotos de câmeras de vigilância poderiam ser analisadas em tempo real para descrever incidentes ou ler placas de veículos. A capacidade multimodal também permite busca por imagem com linguagem natural: o usuário fornece uma imagem de referência e pergunta algo do tipo “Encontre itens similares a isto na base de dados“. O modelo entende a imagem e consegue correlacionar com descrições de outras, atuando como um sistema de busca inteligente que combina visão e texto.

Esses são apenas alguns exemplos ilustrativos. De modo geral, qualquer domínio que envolva informações visuais + interpretação contextual pode se beneficiar do DeepSeek VL. Desde auxiliar pessoas com deficiência visual a entenderem imagens, até analisar dados de sensores (fotos de satélite, imagens de microscopia) juntamente com metadados textuais, as possibilidades são vastas. A chave está em aproveitar as APIs e ferramentas fornecidas para integrar o modelo às soluções existentes, como veremos adiante.

Exemplo de Uso com Código

Para demonstrar na prática como usar o DeepSeek VL, vamos apresentar um exemplo simples em Python. Suponha que queremos que o modelo descreva uma imagem que fornecemos e responda a uma pergunta sobre ela. Primeiro, é necessário instalar e carregar o modelo – isso pode ser feito via Hugging Face Hub, onde os pesos do DeepSeek VL estão hospedados. No exemplo abaixo (adaptado da documentação oficial), faremos o download do modelo de 7 bilhões de parâmetros na variante chat e executaremos uma inferência multimodal:

# Instalação do pacote DeepSeek VL (via repositório GitHub)

!git clone https://github.com/deepseek-ai/DeepSeek-VL && cd DeepSeek-VL && pip install -e .

import torch

from transformers import AutoModelForCausalLM

from deepseek_vl.models import VLChatProcessor

from deepseek_vl.utils.io import load_pil_images

# Carrega o modelo pré-treinado (7B chat) e seu processador associado

model_path = "deepseek-ai/deepseek-vl-7b-chat"

processor = VLChatProcessor.from_pretrained(model_path)

model = AutoModelForCausalLM.from_pretrained(model_path, trust_remote_code=True)

model = model.to(torch.float16).cuda().eval() # usa GPU em meia precisão p/ eficiência

# Prepara a entrada com imagem e texto

conversation = [

{

"role": "User",

"content": "<image_placeholder>Descreva detalhadamente o que você vê nesta imagem e indique se há texto visível.",

"images": ["./exemplo_imagem.jpg"] # caminho para a imagem de exemplo

},

{"role": "Assistant", "content": ""}

]

# Carrega a imagem e formata a entrada para o modelo

pil_images = load_pil_images(conversation) # abre o arquivo de imagem

inputs = processor(conversations=conversation, images=pil_images).to(model.device)

# Gera a resposta multimodal

output = model.generate(**inputs, max_new_tokens=300)

resposta = processor.tokenizer.decode(output[0], skip_special_tokens=True)

print(resposta)

No código acima, usamos a classe VLChatProcessor para preparar a entrada com base na conversa definida (que inclui um prompt do usuário contendo uma imagem e uma pergunta). O placeholder <image_placeholder> indica onde a imagem deve ser inserida no contexto textual. Em seguida, o modelo gera uma sequência de texto como resposta. A variável resposta conterá algo como:

Output (exemplo hipotético):

"Esta imagem mostra uma sala de estar bem iluminada com dois sofás brancos dispostos em L. Há um tapete cinza no chão e uma mesa de centro de vidro com um vaso de flores. Na parede ao fundo, vejo um quadro abstrato com tons de azul. Não há texto visível na imagem."

Esse exemplo ilustra o modelo descrevendo a cena e respondendo à parte da pergunta sobre texto visível. Desenvolvedores podem adaptar facilmente este código para diferentes tarefas: se a intenção for fazer OCR, por exemplo, basta ajustar o prompt do usuário para algo como “Leia o texto presente na imagem anexa”; para VQA, pode-se formular perguntas específicas (“Qual é a cor do carro na foto?”, etc.). O pipeline de uso permanece semelhante: preparar os dados (imagens + prompt), chamar o modelo e decodificar a resposta.

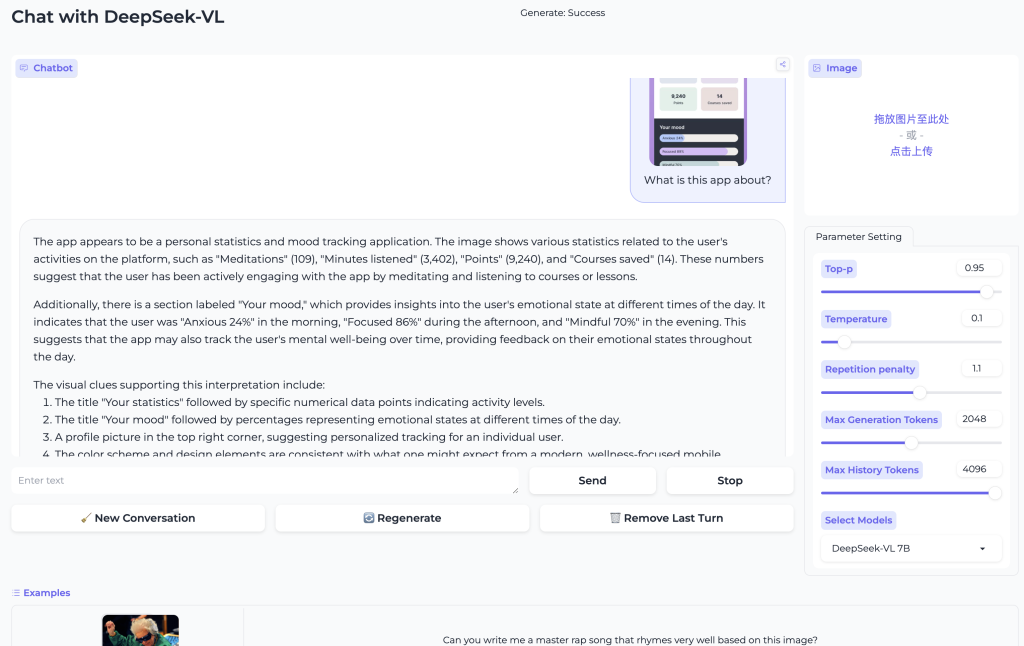

Também é possível utilizar o DeepSeek VL via interface de linha de comando ou front-ends de demonstração. O repositório oficial inclui um script chamado cli_chat.py que permite iniciar um chat interativo com o modelo diretamente no terminal. Além disso, há demos gráficas (Gradio) disponíveis – por exemplo, uma demonstração pública no Hugging Face Spaces onde pode-se fazer upload de imagens e testar perguntas. Esses recursos facilitam a experimentação inicial sem precisar escrever código, mas para integrar em um sistema real convém usar a API ou biblioteca conforme o exemplo acima.

Como Integrar o DeepSeek VL (API e Implementação Local)

Integrar o DeepSeek VL a sua aplicação pode ser feito de duas maneiras principais: executando o modelo localmente (self-hosted) ou consumindo uma API em nuvem fornecida pelos mantenedores do projeto. A escolha depende de fatores como recursos de hardware disponíveis, requisitos de privacidade e volume de uso esperado. Abaixo discutimos ambos os cenários:

1. Integração Local (Self-Hosted): Por ser open source, você pode baixar os pesos do modelo e rodá-lo em seus próprios servidores ou máquinas locais. Os modelos (tanto 1.3B quanto 7B, base e chat) estão disponíveis no Hugging Face Hub, o que permite carregá-los via code como mostrado no exemplo anterior. Para uso local eficiente:

- Certifique-se de ter uma GPU com memória suficiente. A versão de 7B parâmetros em meia precisão (FP16) ocupa por volta de 14-16 GB de VRAM; já a versão de 1.3B é bem mais leve (cerca de ~3 GB em FP16), podendo até rodar em CPU (embora lentamente). Se sua GPU for limitada, considere aplicar técnicas como quantização (ex.: int8) para reduzir o uso de memória, ao custo de alguma perda de precisão.

- Instale as dependências necessárias. O projeto DeepSeek VL disponibiliza o código-fonte no GitHub, então você pode clonar o repositório e instalar (como fizemos com

pip install -e .). Ele internamente usa a biblioteca Transformers do Hugging Face, com algumas extensões (trust_remote_code) para suportar a arquitetura customizada. - Uso do modelo base vs chat: Se sua aplicação requer apenas inferência direta (por exemplo, gerar descrições a partir de imagens sem contexto de conversa), você pode usar o modelo base. Porém, para a maioria dos casos de uso interativos ou orientados a instrução, recomenda-se utilizar o modelo chat, pois ele já foi ajustado para seguir comandos do usuário de forma alinhada (evitando necessidade de prompts elaborados). Ambos estão disponíveis e são carregados de forma similar.

- Lembre-se de respeitar a licença do modelo, embora ela permita uso comercial. Basicamente, pode-se integrar livremente, mas é sempre bom citar a fonte e cumprir quaisquer termos descritos no repositório (como não remover avisos de licença, por exemplo).

Integrar localmente dá mais controle e privacidade – os dados (imagens) não saem do seu ambiente. Isso é importante se você lida com informações sensíveis, pois evita chamadas a serviços externos. A contrapartida é que você precisará fornecer a infraestrutura de computação adequada.

2. Integração via API Cloud: A equipe do DeepSeek oferece um serviço de API na nuvem que expõe seus modelos, eliminando a necessidade de hospedar localmente. Essa API foi concebida para ser compatível com a API da OpenAI, o que significa que quem já utiliza chamadas para modelos como GPT-3/4 pode adaptar com mudanças mínimas a URL e chave de API para acionar o DeepSeek. Para usar essa opção:

- É necessário obter uma chave de API junto à plataforma DeepSeek (geralmente via cadastro no site oficial).

- As requisições seguem o formato REST JSON. Por exemplo, para uma conversa de chat, usa-se um endpoint

/chat/completionscom payload contendo o modelo desejado e a lista de mensagens (similar ao padrão de mensagens do ChatGPT). - No momento, os modelos disponibilizados incluem o deepseek-chat (versão generalista para conversação) e possivelmente outros especializados. A tendência é que o suporte multimodal completo (envio de imagens via API) seja incorporado, caso não esteja disponível ainda, dada a rápida evolução da plataforma (as notas de lançamento indicam planos para suporte a imagens e outras funcionalidades avançadas no ecossistema DeepSeek). Você deve verificar a documentação atualizada para saber se já é possível enviar imagens (provavelmente em base64 ou via URL) diretamente na chamada API.

- Um exemplo simplificado de chamada via

curlpara a API DeepSeek seria:curl https://api.deepseek.com/chat/completions \ -H "Content-Type: application/json" \ -H "Authorization: Bearer SUA_API_KEY_AQUI" \ -d '{ "model": "deepseek-chat", "messages": [ {"role": "system", "content": "Você é um assistente útil."}, {"role": "user", "content": "Olá! Pode se apresentar?"} ] }'Esse request enviaria uma conversa com uma mensagem do usuário, e o modelo retornaria a resposta gerada no formato JSON compatível. Para incluir imagens, a API deve oferecer campos específicos (por exemplo, um campo"image"com um URL ou conteúdo codificado). Caso não ofereça no endpoint público, seria necessário implementar a parte de visão localmente e usar a API apenas para complementos de texto – porém, dado o foco do DeepSeek VL, é esperado que a API suporte entradas multimodais em breve, senão desde já. - A vantagem da API é a escalabilidade e praticidade: você não se preocupa com servidores ou atualizações de modelo, e pode escalar as chamadas conforme demanda (pagando conforme uso, se aplicável). Por outro lado, considere latência (envio de imagens grandes pode ser mais lento) e custo por volume. Além disso, use a API apenas se a política de privacidade for adequada aos dados que você enviará (por exemplo, não mandar imagens confidenciais sem certeza de como serão armazenadas).

Em resumo, para integrar o DeepSeek VL você pode optar pelo caminho self-hosted, ganhando controle total e possivelmente menor custo a longo prazo, ou pela API cloud, obtendo conveniência e escalabilidade imediata. Muitos desenvolvedores durante a prototipação usam primeiro o modelo local (especialmente aproveitando a comunidade e exemplos no Hugging Face) e depois, em produção, decidem se vale manter local ou migrar para a API conforme a necessidade de manter servidores 24/7. De qualquer forma, o suporte a vários métodos de uso torna o DeepSeek VL acessível em diferentes contextos de desenvolvimento.

Boas Práticas e Cuidados de Uso

Ao trabalhar com um modelo multimodal poderoso como o DeepSeek VL, é importante seguir algumas boas práticas para obter os melhores resultados e evitar problemas. Aqui estão algumas dicas e cuidados ao utilizá-lo:

Qualidade das Imagens: Garanta que as imagens fornecidas ao modelo tenham boa resolução e estejam nítidas. Embora o modelo aceite resoluções até 1024×1024 px, imagens muito pequenas ou borradas podem prejudicar a compreensão. Se você precisar analisar um documento ou cena grande, certifique-se de que textos e detalhes estejam legíveis na foto. Considere fazer pré-processamento, como ajustar brilho/contraste ou remover ruído, em imagens muito escuras ou ruidosas antes de enviá-las ao modelo para melhorar a acurácia do OCR e do reconhecimento visual.

Contextualize o Prompt: Ao fazer uma pergunta sobre uma imagem, forneça contexto suficiente no texto do prompt. Por exemplo, em vez de apenas “O que está acontecendo nesta imagem?“, você pode especificar “Nesta foto de um acidente de trânsito, o que está acontecendo?“. Isso ajuda o modelo a saber em que aspectos focar. Da mesma forma, para OCR, seja explícito: “Transcreva o texto do cartaz na imagem” tende a funcionar melhor do que “O que está escrito aí?“. O DeepSeek VL é sensível ao prompt fornecido, especialmente na versão base, então orientar a resposta desejada (sem dar a resposta, claro) é uma boa prática.

Uso da Variante Adequada: Lembre-se de utilizar a variante chat do modelo se seu caso envolve interação com usuários ou seguimento de instruções abertas. A versão base responde conforme foi treinada, podendo gerar textos menos refinados ou fugir do contexto se o prompt não for bem formulado. A versão chat foi deliberadamente afinada para seguir ordens e manter um tom útil e controlado, então é preferível em aplicações como assistentes virtuais, Q&A, etc. Em contrapartida, se você planeja treinar ou ajustar o modelo multimodal para um domínio específico, a versão base é a indicada como ponto de partida (pois não contém as adaptações de diálogo, oferecendo mais “massa bruta” para retreinar).

Gerenciamento de Memória e Desempenho: Ao integrar localmente, monitore o uso de memória (RAM e VRAM). Processar imagens grandes e sequências longas pode consumir bastante recurso. Uma prática recomendada é limitar o tamanho de saída (max_new_tokens) conforme necessário e liberar da GPU quaisquer tensores não utilizados entre chamadas (no PyTorch, por exemplo, usar torch.cuda.empty_cache() se estiver batendo no limite). Para aplicações de tempo real, considere técnicas de otimização como batching de múltiplas requisições se estiver rodando um servidor com o modelo – o DeepSeek VL pode processar um lote de imagens/perguntas juntas, aproveitando melhor a GPU.

Cuidados com Conteúdo e Viés: Assim como outros modelos de linguagem e visão, o DeepSeek VL pode apresentar vieses ou cometer erros de interpretação. Ele foi treinado em dados variados da internet e outras fontes, portanto, pode refletir vieses presentes nesses dados (por exemplo, em descrições de pessoas ou suposições culturais). Use com cautela em aplicações sensíveis – por exemplo, ao descrever imagens de pessoas, evite confiar cegamente em atributos inferidos como idade, gênero ou etnia, pois o modelo pode errar e isso pode ser delicado. Também fique atento a alucinações: se a imagem estiver ambígua ou contiver algo desconhecido, o modelo pode acabar dando uma resposta genérica ou incorreta. Sempre valide as saídas antes de apresentá-las como verdades absolutas aos usuários finais.

Privacidade e Segurança: Se for usar o modelo via API de terceiros, considere as implicações de privacidade de enviar imagens potencialmente confidenciais a um serviço externo. Em cenários médicos ou corporativos, talvez seja obrigatório manter o processamento internamente. Além disso, implemente verificações ou filtros nas entradas dos usuários se seu sistema permitir upload de imagens públicas, para evitar uso indevido (por exemplo, alguém tentar enganar o modelo com conteúdo ofensivo ou dados que você não quer processar). Ferramentas de detecção de conteúdo adulto ou sensível podem ser integradas antes de passar a imagem ao modelo, caso sua aplicação exija conformidade com políticas de conteúdo.

Atualizações e Manutenção: Fique de olho nas atualizações do projeto DeepSeek. Sendo open source e em rápida evolução, é possível que novas versões (por exemplo, DeepSeek VL2, VL3, etc.) surjam trazendo melhorias de desempenho, correções e novas funcionalidades. Embora aqui foquemos na versão inicial, melhorias incrementais podem facilitar seu trabalho (por exemplo, modelos mais leves ou mais precisos). Avalie periodicamente se vale atualizar o modelo em produção para aproveitar essas melhorias. Lembre-se também de atualizar as dependências e seguir as mudanças na API se estiver usando o serviço cloud – isso garantirá compatibilidade e performance ótimas.

Testes e Ajustes Finais: Por fim, teste exaustivamente o modelo no contexto da sua aplicação. Cada caso de uso pode ter nuances – talvez você precise ajustar a forma como constrói o prompt, ou escolher um limiar de confiança para quando o modelo “não tem certeza”. Considere implementar cenários de contingência: se o DeepSeek VL não conseguir extrair determinada informação de uma imagem (ex: OCR falhou em parte do texto), talvez integrar com uma ferramenta especializada naquele ponto possa ajudar (por exemplo, um OCR tradicional como Tesseract como redundância). Combinar as forças do modelo generativo com regras ou modelos dedicados pode elevar a confiabilidade geral do sistema.

Seguindo essas práticas, você aproveitará melhor o potencial do DeepSeek VL, oferecendo respostas visuais inteligentes sem surpresas desagradáveis. Como qualquer tecnologia de IA, uso responsável e bem arquitetado é fundamental para alcançar bons resultados consistentemente.

Desempenho e Limitações

O desempenho do DeepSeek VL tem se mostrado impressionante dentro do escopo para o qual foi projetado. Em diversos benchmarks padrão de visão-linguagem, ele demonstra capacidade de ponta, resolvendo tarefas complexas que antes exigiam sistemas separados de visão computacional e NLP. Por exemplo, em avaliações de Visual Question Answering e OCR, o modelo alcançou pontuações altas, indicando que consegue extrair as respostas corretas da imagem na maioria dos casos. Também foi testado em conjuntos que medem compreensão de documentos e gráficos, obtendo resultados competitivos que validam sua eficácia abrangente. Em suma, do ponto de vista de acurácia, o DeepSeek VL entrega qualidade suficiente para muitas aplicações práticas (desde que operando dentro do domínio visual coberto em seu treinamento).

No entanto, é importante conhecer as limitações atuais do modelo:

Tamanho do Modelo vs. Conhecimento: Com 7B parâmetros na versão mais robusta, o DeepSeek VL é bem menor que alguns modelos proprietários de ponta. Embora otimizado, isso implica que pode haver situações em que seu desempenho fique aquém do desejado, especialmente em perguntas que demandam raciocínio muito elaborado ou conhecimento externo não evidente na imagem. Ele foi treinado em dados até 2024 aproximadamente; portanto, não “sabe” sobre eventos ou objetos surgidos depois disso, a menos que possam ser deduzidos visualmente. Em essência, seu conhecimento de mundo visual e factual está limitado aos dados de treinamento.

Erros de OCR e Detalhes: Apesar de robusto em OCR, o modelo pode errar em casos de texto muito pequeno, fontes incomuns ou fundos muito complexos. Por exemplo, identificar todos os caracteres de um documento muito amassado ou fotografado de ângulo ruim pode falhar. Nesses casos, técnicas tradicionais de processamento de imagem prévio podem ser necessárias (como corrigir perspectiva ou aumentar resolução via super-resolução antes de enviar ao modelo).

Ambiguidade e Contexto Limitado: Se uma imagem for ambígua ou incompleta visualmente, o DeepSeek VL pode dar respostas genéricas ou até factualmente incorretas – fenômeno conhecido como alucinação. Por exemplo, se perguntado “Esta pessoa parece confiável?” com base apenas em uma foto, o modelo não tem como saber realmente e pode acabar inferindo algo inconsistente. Ele não possui intuição genuína ou capacidade de verdadeiramente compreender intenções humanas; opera correlacionando padrões aprendidos. Logo, perguntas muito subjetivas ou que fujam do que os dados de treinamento continham podem levar a respostas falhas.

Tempo de Processamento: Rodar um modelo multimodal grande envolve etapas pesadas – a codificação da imagem, a geração de resposta token a token – o que pode ser relativamente lento. Em uma GPU moderna, o DeepSeek VL 7B pode levar poucos segundos para responder uma pergunta média, mas em CPU esse tempo cresce significativamente. Portanto, para aplicações em tempo real ou de alto throughput, pode ser um limitador. A inferência batch e possíveis técnicas de compressão do modelo (quantização, poda) ajudam, mas ainda assim não espere respostas em milissegundos como obteria de um sistema totalmente pré-otimizado em C++ ou similar. Há sempre um compromisso entre velocidade e precisão: usar a variante 1.3B seria mais rápido, porém a compreensão da imagem pode ser inferior (essa versão “mini” pode falhar em entender cenas complexas que o 7B consegue).

Suporte Multilíngue: O DeepSeek VL foi treinado predominantemente em inglês (e parcialmente em chinês, dado que os autores incluíram dados em múltiplos idiomas nas fine-tunes). Ele possui alguma capacidade de entender e responder em outros idiomas, inclusive português, mas essa não é sua principal fortaleza. Em perguntas feitas em português sobre imagens, ele pode até acertar, mas a fluência da resposta ou precisão pode variar. Uma solução, se seu público é brasileiro, seria considerar traduzir internamente a pergunta para inglês, alimentar o modelo, e depois traduzir a resposta de volta – embora isso adicione complexidade, pode melhorar a qualidade final aproveitando ao máximo o treinamento em inglês. Alternativamente, monitorar se surgem versões multilíngues ou adaptadas do DeepSeek VL, visto que a comunidade às vezes lança fine-tuning em outras línguas. De qualquer forma, se espera usar diretamente em português, recomendo realizar testes específicos para ver até que ponto as respostas são satisfatórias e eventualmente complementar com pós-processamento (por exemplo, corrigindo pequenos erros gramaticais que possam surgir).

Limite de Contexto: O modelo aceita até 4096 tokens de entrada (somando texto + tokens visuais). Isso normalmente é suficiente para uma imagem e uma pergunta longa, ou até uma página inteira de texto OCR. Contudo, se você tentar inserir várias páginas de uma vez ou um chat muito extenso sem reiniciar, pode atingir o limite. Fique atento a isso – se o modelo começar a truncar respostas ou se recusar a continuar, pode ser que o contexto tenha estourado. A solução é resumir ou dividir informações entre rodadas de interação.

Reconhecendo essas limitações, fica claro que o DeepSeek VL não é a solução mágica para todos os problemas, mas sim uma ferramenta extremamente avançada para um conjunto de problemas bem delimitados (visão + linguagem em contexto estático). Em aplicações críticas, deve ser usado como apoio ao especialista humano, e não substituto. Em aplicações autônomas, deve haver sempre verificações adicionais para garantir confiabilidade. Ainda assim, considerando que é uma tecnologia relativamente nova e de código aberto, o nível de desempenho alcançado é notável e tende a melhorar com futuras iterações.

Conclusão

O DeepSeek VL representa um marco importante na convergência entre visão computacional e linguagem natural. Como discutimos, ele permite compreensão multimodal integrada, capacitando desenvolvedores a criar sistemas que “enxergam” e “falam” de maneira unificada. De descrições automatizadas de imagens e resposta a perguntas visuais, até assistentes inteligentes que conseguem analisar o que veem, as possibilidades são vastas e animadoras para diversas indústrias.

Para desenvolvedores brasileiros, a disponibilidade do DeepSeek VL como uma solução open source traz autonomia e economia – você pode testar, iterar e implantar aplicações com esse modelo sem barreiras de acesso. A chave é seguir as boas práticas destacadas, entendendo seus pontos fortes e fracos, para tirar o melhor proveito da ferramenta. Recomendamos fortemente experimentar o DeepSeek VL em pequenos projetos piloto: faça o download dos modelos ou chame a API, passe algumas imagens de exemplo do seu domínio e avalie os resultados. Essa etapa hands-on vai demonstrar claramente o valor que a abordagem multimodal pode agregar ao seu produto ou pesquisa.

Em termos de próximos passos, fique atento às atualizações da comunidade DeepSeek – novas versões e melhorias podem surgir rapidamente, acompanhando o ritmo acelerado do campo de IA generativa. Considere também participar de fóruns ou grupos (como o Discord oficial do projeto) para trocar experiências e obter suporte direto de outros usuários e dos mantenedores.

Chamada para ação: Pronto para dar vida às suas ideias com IA multimodal? Então não hesite – acesse o repositório do DeepSeek VL ou sua página no Hugging Face, baixe um modelo e comece a criar. Seja implementando um chatbot que conversa sobre imagens ou uma ferramenta interna de análise de documentos, o DeepSeek VL fornece a base necessária. Os desenvolvedores que incorporarem visão e linguagem em suas aplicações agora estarão na vanguarda de uma nova geração de experiências impulsionadas por IA. Experimente o DeepSeek VL hoje mesmo e descubra como ele pode revolucionar seus projetos.